L’industrie automobile traverse une révolution technologique sans précédent. L’intelligence artificielle redéfinit fondamentalement notre rapport à la conduite, transformant les véhicules en machines intelligentes capables d’analyser, d’apprendre et de prendre des décisions en temps réel. Cette évolution technologique majeure s’appuie sur des décennies de recherche en informatique, en robotique et en apprentissage automatique pour créer des systèmes toujours plus sophistiqués. Les constructeurs automobiles investissent massivement dans ces technologies, conscients que l’avenir de la mobilité se joue aujourd’hui. Cette transformation dépasse largement le simple ajout de fonctionnalités : elle repense entièrement l’expérience de conduite pour la rendre plus sûre, plus efficace et plus intuitive.

Systèmes ADAS et capteurs intelligents : tesla autopilot, waymo LiDAR et caméras haute résolution

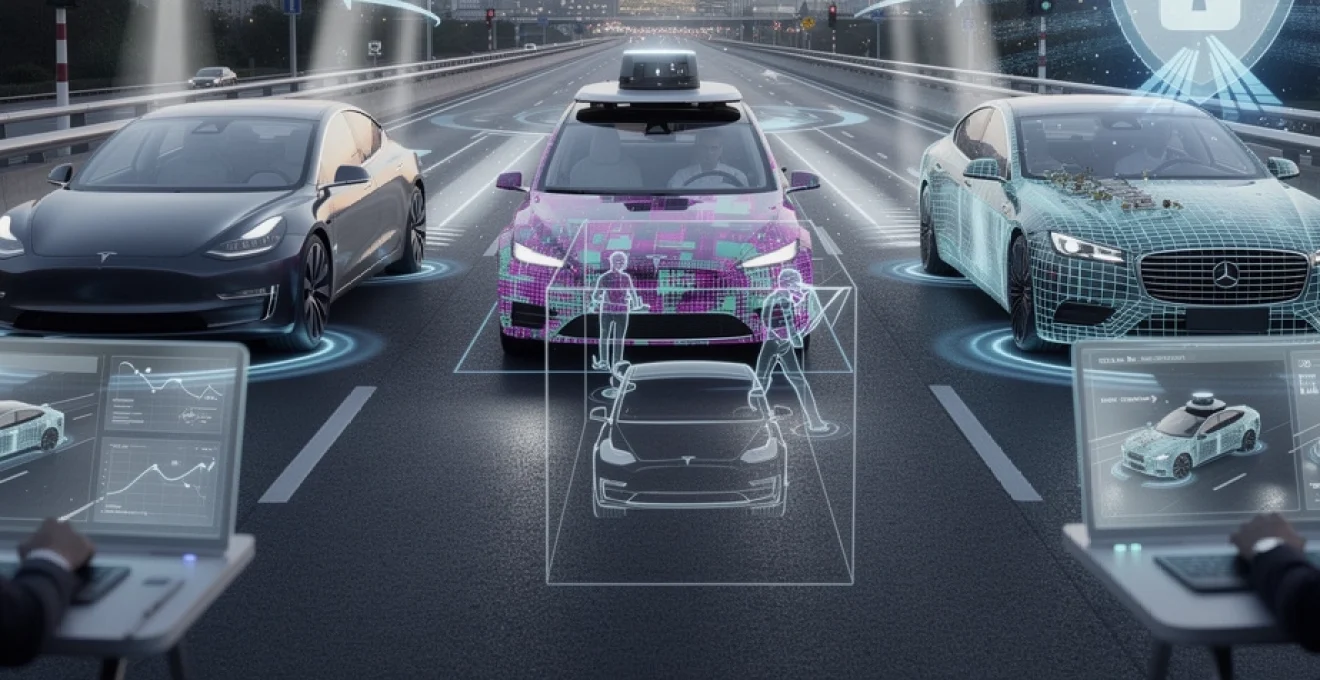

Les systèmes avancés d’aide à la conduite, communément appelés ADAS (Advanced Driver Assistance Systems), constituent l’épine dorsale de l’intelligence artificielle embarquée. Ces technologies représentent une évolution majeure par rapport aux systèmes de sécurité passifs traditionnels, en intégrant des capacités de perception active et de prise de décision automatisée. Tesla Autopilot, l’un des pionniers dans ce domaine, illustre parfaitement cette approche révolutionnaire en combinant vision par ordinateur et apprentissage profond.

L’efficacité de ces systèmes repose sur leur capacité à traiter simultanément des millions de points de données provenant de multiples sources. Les caméras haute résolution capturent des images à 60 images par seconde, permettant une analyse détaillée de l’environnement routier. Cette fusion sensorielle crée une représentation tridimensionnelle précise de l’espace environnant le véhicule, essentielle pour les décisions de navigation automatisée.

Technologie LiDAR velodyne et radar à ondes millimétriques pour la détection d’obstacles

Le LiDAR Velodyne révolutionne la détection d’obstacles grâce à sa capacité unique à mesurer les distances avec une précision millimétrique. Cette technologie émet des impulsions laser qui se reflètent sur les objets environnants, créant un nuage de points tridimensionnel extrêmement détaillé. Les systèmes LiDAR modernes peuvent identifier des objets situés jusqu’à 200 mètres de distance, même dans des conditions de faible visibilité.

Les radars à ondes millimétriques complètent efficacement le LiDAR en offrant des performances supérieures dans des conditions météorologiques difficiles. Ces capteurs fonctionnent dans la bande de fréquences 76-81 GHz et peuvent détecter des objets métalliques à travers la pluie, le brouillard ou la neige. Leur robustesse environnementale en fait des composants indispensables pour garantir la fiabilité des systèmes de conduite autonome.

Vision par ordinateur NVIDIA drive PX2 et traitement d’images en temps réel

La plateforme NVIDIA Drive PX2 représente un bond technologique majeur dans le traitement des images automobiles. Cette unité de calcul haute performance peut traiter simultanément les flux vidéo de douze caméras, analysant chaque image en moins de 30 millisecondes. L’architecture GPU spécialisée permet d’exécuter des réseaux de neurones complexes directement dans le véhicule, sans dépendre d’une connexion internet.

Le traitement d’images en temps réel s’appuie sur

des algorithmes de vision par ordinateur capables de détecter, classer et localiser en temps réel les objets présents sur la chaussée. Concrètement, chaque frame vidéo est analysée par des réseaux de neurones convolutifs qui identifient les piétons, les véhicules, les deux-roues, les marquages au sol ou encore les trottoirs. Le système associe ensuite ces informations à la vitesse du véhicule, à sa trajectoire et aux données cartographiques pour anticiper les situations à risque. Cette approche permet une prise de décision en quelques dizaines de millisecondes, un délai indispensable pour éviter un obstacle imprévu ou adapter la trajectoire dans un virage serré.

La plateforme NVIDIA Drive PX2 est conçue pour être évolutive : les constructeurs peuvent déployer de nouvelles fonctionnalités de conduite autonome via des mises à jour logicielles. L’intelligence artificielle embarquée profite ainsi des progrès continus en matière de Deep Learning sans modifier le matériel. Pour vous, conducteur, cela se traduit par une expérience de conduite qui s’améliore au fil du temps : meilleure reconnaissance des piétons de nuit, adaptation plus fine aux embouteillages, freinages d’urgence plus efficaces. On assiste ainsi à une convergence entre l’industrie automobile et le monde du logiciel, où la voiture devient un système en perpétuelle amélioration.

Fusion sensorielle multi-modale et algorithmes de perception 3D

La véritable révolution des systèmes ADAS repose sur la fusion sensorielle multi-modale. Plutôt que de s’appuyer sur un seul type de capteur, les véhicules combinent les données issues de caméras, radars, LiDAR, GPS et inertiels (IMU). Chaque capteur a ses forces et ses faiblesses : la caméra « voit » les couleurs et les panneaux, le radar mesure les vitesses relatives, le LiDAR reconstruit une scène 3D précise, tandis que le GPS offre un positionnement global. Les algorithmes de perception 3D viennent unifier ces flux de données hétérogènes pour produire une représentation cohérente et robuste de l’environnement routier.

Cette fusion repose sur des techniques avancées de filtrage probabiliste, comme les filtres de Kalman étendus ou les approches basées sur les réseaux neuronaux. Imaginez un chef d’orchestre qui synchronise plusieurs musiciens : si l’un d’eux joue faux (un capteur perturbé par la pluie, par exemple), les autres viennent corriger l’erreur pour conserver l’harmonie. De la même manière, un véhicule autonome peut continuer de rouler en sécurité même si une caméra est éblouie par le soleil, grâce aux informations complémentaires fournies par le radar et le LiDAR. Cette redondance est essentielle pour garantir un haut niveau de sécurité, en particulier pour les fonctions de conduite autonome avancées.

Les algorithmes de perception 3D permettent en outre de prédire le mouvement des autres usagers de la route en estimant leur trajectoire probable dans les secondes à venir. Par exemple, un piéton se trouvant près d’un passage protégé sera traité différemment d’un piéton statique derrière une barrière. Ces capacités prédictives, combinées à la fusion sensorielle multi-modale, sont au cœur de la conduite assistée intelligente que l’on retrouve déjà dans plusieurs modèles premium et véhicules de test comme ceux de Waymo ou de Cruise.

Capteurs ultrasons bosch et détection de proximité pour le stationnement automatisé

Si les LiDAR et radars gèrent les longues et moyennes distances, les capteurs ultrasons, souvent fournis par des équipementiers comme Bosch, prennent le relais pour la détection de proximité. Ces petits capteurs, intégrés dans les pare-chocs, émettent des ondes sonores haute fréquence qui se réfléchissent sur les obstacles proches : poteaux, trottoirs, autres voitures, murs de parking. Ils sont particulièrement efficaces à courte distance, là où la précision au centimètre près est cruciale, notamment lors des manœuvres de stationnement automatisé.

Les systèmes de parking assist et de stationnement entièrement automatisé s’appuient sur un réseau de plusieurs capteurs ultrasons répartis autour du véhicule. L’IA embarquée interprète les signaux reçus pour cartographier l’espace disponible, calculer une trajectoire optimale et contrôler automatiquement le volant, l’accélérateur et le frein. Pour vous, cela signifie moins de stress dans les parkings étroits, une réduction du risque de rayures ou de chocs légers, et une meilleure accessibilité pour les conducteurs peu à l’aise avec les manœuvres. À terme, ces mêmes capteurs participeront aux fonctions de voiturier automatique, où la voiture ira se garer seule dans un parking connecté.

Algorithmes d’apprentissage automatique et réseaux de neurones convolutifs pour la conduite autonome

Derrière ces capteurs intelligents, ce sont les algorithmes d’apprentissage automatique qui donnent vraiment vie à l’intelligence artificielle automobile. Les véhicules modernes ne se contentent plus d’exécuter des règles prédéfinies : ils apprennent à partir de gigantesques volumes de données collectés sur des millions de kilomètres parcourus. Les réseaux de neurones convolutifs (CNN), les réseaux récurrents (RNN) ou encore les algorithmes d’apprentissage par renforcement sont au cœur de cette nouvelle génération de systèmes de conduite autonome. Ils permettent à la voiture de reconnaître un panneau, d’anticiper la trajectoire d’un cycliste ou de choisir la meilleure voie sur autoroute.

Pour les constructeurs et les équipementiers, la maîtrise de ces technologies de Deep Learning avec TensorFlow, PyTorch ou d’autres frameworks open source est devenue un enjeu stratégique. Vous vous demandez peut-être : comment une voiture peut-elle « apprendre » comme un humain ? La réponse réside dans l’entraînement de ces modèles sur des centres de calcul surpuissants, avant de les embarquer dans les unités de contrôle du véhicule. Une fois déployés, ces modèles continuent parfois d’affiner leurs performances grâce aux données remontées par les flottes connectées, dans le respect des contraintes de confidentialité et de cybersécurité.

Deep learning avec TensorFlow et PyTorch pour la reconnaissance d’objets routiers

Les réseaux de neurones convolutifs sont particulièrement efficaces pour la reconnaissance d’objets routiers. En s’appuyant sur des frameworks comme TensorFlow ou PyTorch, les ingénieurs entraînent des modèles capables d’identifier avec une précision supérieure à 95 % des éléments variés : piétons, vélos, motos, bus, feux tricolores, panneaux de limitation de vitesse, cônes de chantier, etc. Pour y parvenir, ils utilisent des jeux de données colossaux composés de millions d’images annotées, capturées dans des conditions de circulation réelles (jour, nuit, pluie, neige, brouillard).

Le principe est similaire à l’apprentissage d’un enfant qui regarde des milliers de photos de voitures pour apprendre à les distinguer des camions ou des motos. Mais ici, l’IA automobile va bien plus loin : elle doit reconnaître ces objets en temps réel, dans des scènes complexes et parfois ambigües. Par exemple, distinguer un sac plastique emporté par le vent d’un animal traversant la route. En utilisant les capacités de parallélisation des GPU, TensorFlow et PyTorch accélèrent considérablement l’entraînement de ces modèles, permettant aux constructeurs de tester rapidement différentes architectures (ResNet, EfficientNet, Transformers visuels, etc.) pour optimiser la sécurité et la réactivité du véhicule.

Une fois entraînés, ces modèles sont compressés et optimisés pour être exécutés sur des plateformes embarquées comme NVIDIA Drive, Qualcomm Snapdragon Ride ou des puces propriétaires (Tesla FSD, par exemple). L’un des grands défis consiste à trouver le bon compromis entre précision, consommation énergétique et latence : l’IA de la voiture doit prendre des décisions en quelques millisecondes, sans vider la batterie ni surchauffer les composants électroniques.

Réseaux de neurones récurrents LSTM pour la prédiction de trajectoires

Reconnaître les objets ne suffit pas : il faut aussi anticiper leur mouvement. Les réseaux de neurones récurrents, et en particulier les architectures LSTM (Long Short-Term Memory), sont utilisés pour la prédiction de trajectoires. Ces modèles prennent en compte la dimension temporelle des données : ils analysent la position et la vitesse des véhicules, piétons ou cyclistes sur plusieurs instants consécutifs, puis prédisent où ils se trouveront dans les prochaines secondes. C’est un peu comme un joueur d’échecs qui ne se contente pas de voir le plateau, mais imagine les coups suivants.

Concrètement, un système de conduite autonome peut ainsi prévoir qu’un piéton qui s’avance vers un passage clouté a de fortes chances de traverser, même s’il n’a pas encore posé le pied sur la chaussée. De même, il peut anticiper la trajectoire d’une voiture qui met son clignotant pour changer de voie ou d’un deux-roues qui se faufile entre les files. Cette prédiction de trajectoires permet au véhicule autonome d’ajuster sa vitesse, de modifier sa trajectoire ou d’augmenter ses distances de sécurité, contribuant à une conduite plus douce et plus sûre.

Les réseaux LSTM sont parfois combinés à des approches plus récentes comme les Transformers temporels ou les modèles de graphes (GNN) pour mieux modéliser les interactions complexes entre plusieurs usagers de la route. Ces avancées sont cruciales pour atteindre les niveaux d’autonomie 4 et 5, où le véhicule doit gérer seul des scénarios urbains denses et imprévisibles, sans l’aide du conducteur.

Apprentissage par renforcement et algorithmes q-learning appliqués à la navigation

L’apprentissage par renforcement joue un rôle croissant dans le développement des systèmes de conduite autonome. Inspirés de la manière dont nous apprenons par essais et erreurs, les algorithmes comme le Q-learning ou le Deep Q-Network (DQN) permettent à un agent (ici, la voiture virtuelle) d’apprendre à prendre les meilleures décisions pour atteindre un objectif donné, tout en maximisant une récompense. Par exemple, trouver l’itinéraire le plus rapide tout en respectant les limitations de vitesse et en minimisant la consommation d’énergie.

Dans des environnements de simulation ultra-réalistes, les véhicules autonomes virtuels peuvent parcourir des milliards de kilomètres en quelques semaines, confrontés à d’innombrables situations de circulation : dépassements, insertions sur autoroute, priorités à droite, ronds-points, zones de travaux, etc. À chaque action (accélérer, freiner, tourner, changer de voie), l’algorithme reçoit une récompense positive ou négative en fonction du résultat (conduite fluide, freinage brusque, quasi-collision). Progressivement, le système apprend des stratégies de navigation efficaces et sûres, qu’il pourra ensuite appliquer dans le monde réel.

Cette approche permet aussi d’explorer des scénarios rares mais critiques (enfants surgissant entre deux voitures, véhicule en contre-sens, obstacle inattendu), difficilement reproductibles en tests physiques. Bien sûr, ces politiques apprises doivent ensuite être rigoureusement validées et encadrées par des règles de sécurité explicites. Mais l’apprentissage par renforcement offre un complément puissant aux approches supervisées classiques, en donnant à l’IA automobile une forme de « bon sens » acquis par l’expérience.

Computer vision OpenCV et détection de panneaux de signalisation par YOLO

La Computer Vision traditionnelle, avec des bibliothèques comme OpenCV, reste un pilier des systèmes de perception, en complément du Deep Learning. Elle est utilisée pour des tâches de prétraitement comme la correction de distorsion des caméras, la détection des lignes de route, ou le recalage des images. Sur cette base, des modèles de détection d’objets en temps réel comme YOLO (You Only Look Once) sont déployés pour identifier les panneaux de signalisation et autres éléments critiques pour la conduite autonome.

YOLO est particulièrement adapté à l’environnement automobile car il peut analyser une image complète en une seule passe, offrant une détection des objets extrêmement rapide, souvent à plus de 30 images par seconde sur du matériel embarqué optimisé. Pour la détection de panneaux de signalisation, les modèles YOLO sont entraînés sur des jeux de données spécifiques contenant des milliers de panneaux de limitation de vitesse, d’interdiction de dépasser, d’arrêts, de sens interdits, propres à chaque pays. Cela permet à la voiture de s’adapter aux règles locales, même lorsque la cartographie n’est pas parfaitement à jour.

En combinant OpenCV pour le traitement d’image de bas niveau (ajustement de contraste, filtrage de bruit, détection de contours) et YOLO pour la reconnaissance d’objets, les systèmes de conduite assistée gagnent en robustesse et en précision. Pour vous, cela signifie une meilleure fiabilité des régulateurs de vitesse adaptatifs, qui ajustent automatiquement votre allure en fonction des panneaux détectés, ou des alertes de dépassement de vitesse qui tiennent compte des limitations réelles de la route.

Véhicules autonomes level 4 et 5 : google waymo, cruise origin et mercedes EQS

Les niveaux 4 et 5 d’autonomie, définis par la SAE (Society of Automotive Engineers), représentent le Graal de la conduite autonome. Au niveau 4, le véhicule peut se conduire seul dans des zones et conditions définies (par exemple, un centre-ville cartographié ou une autoroute), sans intervention humaine dans la plupart des cas. Au niveau 5, aucune intervention du conducteur n’est nécessaire, quelle que soit la route ou la météo. Des acteurs comme Google Waymo, Cruise Origin ou encore certains modèles haut de gamme comme la Mercedes EQS s’approchent progressivement de ces niveaux.

Waymo opère déjà des services de robotaxis sans conducteur de sécurité dans certaines villes américaines, démontrant la faisabilité technique du niveau 4 dans des environnements contrôlés. Cruise Origin, véhicule conçu sans volant ni pédales, illustre quant à lui la vision d’une mobilité partagée entièrement autonome, pensée dès le départ pour l’usage de flotte. De son côté, Mercedes a obtenu en Europe l’homologation du système Drive Pilot de niveau 3 sur certains tronçons d’autoroute, et prépare progressivement le terrain pour des fonctions plus avancées sur des véhicules comme l’EQS.

Pour le grand public, la distinction entre les niveaux peut sembler théorique, mais elle a un impact direct sur votre rôle en tant que conducteur. Dans un véhicule de niveau 2 ou 3, vous devez rester vigilant et prêt à reprendre la main à tout moment. À partir du niveau 4, dans les zones autorisées, vous devenez davantage un passager, libre de lire, travailler ou vous divertir pendant le trajet. Cela change radicalement notre rapport à la voiture, qui passe de simple moyen de transport à véritable espace de vie connecté, comme l’imaginent déjà certains constructeurs avec des intérieurs modulables et des interfaces immersives.

Infrastructure V2X et communication véhicule-infrastructure intelligente

Pour que l’intelligence artificielle automobile déploie tout son potentiel, les véhicules ne doivent pas seulement « voir » leur environnement : ils doivent aussi communiquer avec lui. C’est tout l’enjeu des technologies V2X (Vehicle-to-Everything), qui englobent la communication entre véhicules (V2V), avec l’infrastructure (V2I), avec les piétons (V2P) ou encore avec le réseau (V2N). Grâce aux connexions 4G/5G, au Wi-Fi dédié (DSRC, ITS-G5) ou aux futurs réseaux 6G, les voitures peuvent échanger des informations en temps réel pour améliorer la sécurité, la fluidité du trafic et l’efficacité énergétique.

Imaginez une voiture qui reçoit, plusieurs centaines de mètres à l’avance, l’information qu’un carrefour est bloqué ou qu’un accident vient de se produire, avant même que cela ne soit visible à la caméra. Ou encore des feux tricolores intelligents qui dialoguent avec les véhicules pour optimiser la cadence des feux et réduire les embouteillages. Cette infrastructure intelligente permet à l’IA embarquée de prendre des décisions plus éclairées, en combinant la perception locale (capteurs du véhicule) avec une vision globale (données du réseau et de la route).

Les projets pilotes de V2X se multiplient en Europe, en Asie et en Amérique du Nord, souvent dans le cadre de villes intelligentes. Pour vous, conducteur, les bénéfices sont concrets : alertes de franchissement de feu rouge, avertissements de véhicule en panne sur la voie, adaptation de la vitesse pour passer au vert sans s’arrêter, optimisation du trajet en fonction de l’occupation des parkings. À plus long terme, cette communication véhicule-infrastructure sera indispensable pour coordonner de vastes flottes de véhicules autonomes et éviter les congestions massives dans les grandes agglomérations.

Cybersécurité automobile et protection contre les attaques sur ECU et systèmes embarqués

À mesure que la voiture devient un objet connecté à part entière, la cybersécurité automobile devient un enjeu majeur. Chaque nouveau capteur, chaque module de communication et chaque ligne de code est une porte d’entrée potentielle pour des attaques malveillantes. Les unités de contrôle électroniques (ECU), qui pilotent le moteur, le freinage, la direction ou encore les systèmes ADAS, doivent être protégées contre les tentatives de prise de contrôle à distance. Des cas de piratage démonstratifs, comme l’attaque médiatisée d’une Jeep Cherokee en 2015, ont montré qu’il ne s’agit pas d’un risque théorique.

Pour y faire face, les constructeurs et équipementiers déploient des architectures de sécurité multicouches : segmentation des réseaux internes, chiffrement des communications, authentification forte des mises à jour logicielles, systèmes de détection d’intrusion embarqués (IDS), etc. Les ECU critiques sont souvent isolés du reste du réseau embarqué, un peu comme des coffres-forts numériques, afin de limiter les conséquences d’une intrusion. Les mises à jour « over-the-air », qui permettent de corriger des failles sans passage en atelier, s’accompagnent de protocoles de signature et de vérification très stricts pour éviter toute manipulation.

En tant qu’utilisateur, quelques bonnes pratiques permettent de limiter les risques : maintenir son véhicule à jour, éviter d’installer des accessoires connectés non certifiés, ou encore sécuriser l’accès à son compte de services en ligne (applications mobiles de contrôle, par exemple). Les normes internationales de cybersécurité automobile, comme l’ISO/SAE 21434, imposent désormais aux constructeurs une approche de sécurité dès la conception (« security by design »). Cela signifie que chaque fonctionnalité liée à l’intelligence artificielle est pensée avec un niveau de protection adapté, afin que la voiture reste un espace sûr, aussi bien physiquement que numériquement.

Réglementation européenne et homologation des systèmes de conduite automatisée selon l’UNECE

L’essor de l’intelligence artificielle dans l’automobile ne peut se faire sans un cadre réglementaire solide. En Europe, l’homologation des systèmes de conduite automatisée est largement encadrée par les règlements de l’UNECE (Commission économique pour l’Europe des Nations unies) et par les textes européens comme le Règlement Général de Sécurité (GSR). Ces règles définissent les exigences techniques et les procédures de test que les constructeurs doivent respecter avant de mettre sur le marché des véhicules dotés de fonctions d’automatisation avancées.

Par exemple, le règlement UNECE n°157 encadre spécifiquement les systèmes de maintien de voie automatisé (ALKS) pour les autoroutes, en précisant les conditions de fonctionnement, les limites de vitesse, les scénarios à gérer et les exigences en termes de reprise en main par le conducteur. D’autres règlements imposent la présence de dispositifs d’alerte de somnolence, de freinage d’urgence automatique ou de détection d’obstacles, souvent basés sur l’intelligence artificielle. L’objectif est clair : tirer parti des bénéfices de la conduite assistée pour réduire les accidents, tout en évitant une confiance excessive dans des systèmes encore perfectibles.

La question de la responsabilité en cas d’accident impliquant un système de conduite automatisée est également au cœur des débats. Qui est responsable si un véhicule autonome de niveau 4 commet une erreur : le conducteur, le constructeur, l’éditeur de logiciel, le gestionnaire d’infrastructure ? Les législateurs européens travaillent à clarifier ces points, notamment via des directives sur la responsabilité des produits et sur l’IA de confiance. Pour vous, cela signifie que, progressivement, le cadre juridique s’adaptera pour protéger les usagers tout en favorisant l’innovation.

Enfin, la réglementation européenne insiste sur la transparence et l’explicabilité des systèmes d’intelligence artificielle utilisés dans les véhicules. Les constructeurs doivent documenter le fonctionnement de leurs algorithmes, définir clairement leurs limites et prévoir des mécanismes de désactivation ou de reprise en main. Cette approche vise à construire la confiance du public : en sachant ce que leur voiture peut faire – et ne pas faire – les conducteurs seront plus enclins à adopter ces technologies, tout en restant des acteurs vigilants de leur propre sécurité.